Guía Completa de Análisis Temático: 7 Fases para Aprender Análisis Cualitativo

📑 Ver contenido

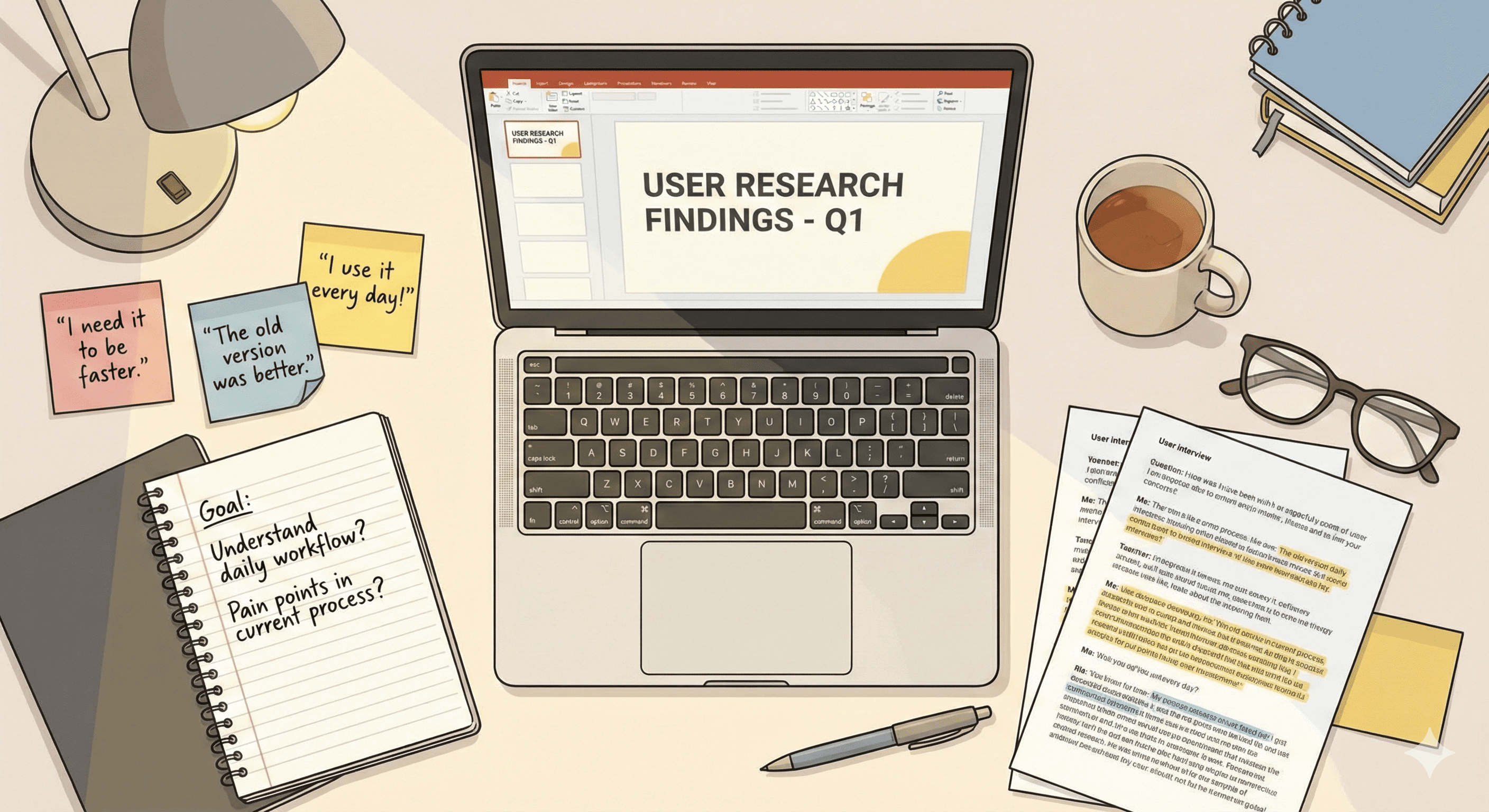

Si alguna vez te has preguntado “¿cómo analizar entrevistas de usuarios?” o “¿qué hacer con todas estas transcripciones?”, este artículo es para ti. El análisis temático es el punto de partida útil para aprender análisis cualitativo en UX Research.

¿Qué es el análisis temático?

El análisis temático es un método para identificar patrones (temas) a través de datos cualitativos. No es solo “leer las entrevistas y sacar conclusiones” — es un proceso sistemático y riguroso que da credibilidad a tus hallazgos.

Imagina que tienes 15 entrevistas con usuarios de una app bancaria. El análisis temático te permite:

- Encontrar patrones de comportamiento repetidos

- Identificar problemas de usabilidad comunes

- Descubrir necesidades no expresadas explícitamente

- Justificar decisiones de diseño con evidencia sólida

¿Por qué el análisis temático es ideal para empezar?

Según Lester, Cho y Lochmiller (2020), el análisis temático ofrece tres ventajas clave:

- Flexibilidad teórica: Puedes usarlo con cualquier enfoque (UX, CX, Service Design, etc.)

- Prácticas comunes: Usa técnicas que encontrarás en otros métodos cualitativos

- Aplicabilidad amplia: Funciona con entrevistas, observaciones, encuestas abiertas, etc.

¿Cuándo usar análisis temático?

Úsalo cuando necesites:

- Analizar entrevistas de descubrimiento con usuarios

- Interpretar observaciones de pruebas de usabilidad

- Entender respuestas abiertas de encuestas

- Identificar patrones en diarios de usuario

- Analizar feedback cualitativo de stakeholders

Quizás no es lo mejor si:

- Solo tienes 2-3 entrevistas (demasiado poco)

- Necesitas análisis conversacional detallado (mejor: Discourse Analysis)

- Tu pregunta de investigación es muy específica y ya tienes una teoría a probar (mejor: Análisis de Contenido dirigido)

Las 7 fases del análisis temático

Basándome en el framework de Lochmiller y Lester (2017), aquí están las 7 fases que debes seguir:

Fase 1: Preparar y organizar los datos

¿Qué hacer?

- Reúne todos los archivos de audio/video en una carpeta

- Crea una nomenclatura consistente (ej:

P01_discovery_2025-02-10.mp3) - Genera un catálogo maestro de datos con:

- Fuente de datos

- Ubicación del archivo

- Fecha de recolección

- Participante/rol

Ejemplo:

Entrevistas_Discovery/

├── P01_usuario_app_bancaria_2025-02-05.mp3

├── P02_usuario_app_bancaria_2025-02-06.mp3

├── ...

└── catalogo_datos.xlsx (nombre, rol, fecha, duración, notas)

Herramientas recomendadas:

- NVivo, ATLAS.ti, o MAXQDA para importar datos

- Google Drive o Dropbox para organizar archivos

- Excel/Notion para el catálogo maestro (yo uso excel)

Fase 2: Transcribir los datos

Tipos de transcripción:

| Tipo | Qué incluye | Cuándo usarlo |

|---|---|---|

| Verbatim | Cada palabra, pausa, risa, muletilla | Análisis temático profundo |

| Inteligente | Palabras exactas, sin muletillas | Mayoría de análisis UX |

| Resumida | Ideas clave, no literal | Solo para exploración inicial |

¿Transcribir tu misma o con ayuda?

Ventajas de transcribir tú misma:

- Te familiarizas profundamente con los datos

- Detectas insights mientras transcribes (los puewdes ir anotando)

- Acelera el análisis posterior

Realidad práctica:

- 1 hora de audio = 4-6 horas de transcripción manual

- Herramientas de transcripción automática (Otter.ai, Fathom, Google) reducen esto a 1 hora de revisión

Mi recomendación: Usa transcripción automática + revisión manual. Obtienes lo mejor de ambos mundos.

Fase 3: Familiarizarte con los datos

Actividades clave:

- Lee todas las transcripciones sin codificar (solo leer)

- Escucha los audios mientras lees para captar emoción y énfasis

- Anota primeras impresiones en los márgenes:

- “¡Todos mencionan frustración con el flujo de pago!”

- “Patrón: usuarios >50 años prefieren llamar al banco”

- “Gap: nadie habló de notificaciones push”

Tiempo recomendado: 30-60 minutos por entrevista de 1 hora.

Ejemplo concreto:

Si estás analizando pruebas de usabilidad de una app de salud, podrías anotar:

- “P03 se confundió 3 veces con el botón ‘Guardar’ vs ‘Enviar’”

- “P07 esperaba confirmar con un código SMS”

- “Patrón emergente: usuarios no confían en guardar datos médicos sin confirmación visual”

Fase 4: Memoing (conversación contigo misma sobre los datos)

¿Qué es un memo?

Un memo es una nota analítica donde reflexionas sobre:

- Interpretaciones emergentes

- Conexiones entre participantes (esto lo dijo también el P01!)

- Posibles sesgos tuyos (super relevante en investigación cualitativa)

- Preguntas para investigar más (¿Por qué no confían en guardar datos?)

Ejemplo de memo:

## Memo: Confianza en Datos Médicos (2025-02-13)

**Observación:** 8 de 12 participantes expresaron desconfianza al guardar

datos médicos en la app sin confirmación explícita.

**Interpretación inicial:** Esto podría estar relacionado con:

- Normas culturales sobre privacidad médica en Chile

- Falta de feedback visual después de "Guardar"

- Experiencias previas con apps que "pierden" datos

**Pregunta para investigar:** ¿Es la falta de confirmación visual,

o es desconfianza en la tecnología en general?

**Posible sesgo mío:** Yo confío en apps porque soy tech-savvy.

Debo no proyectar mi confianza en los usuarios.

**Siguiente paso:** Revisar si usuarios mencionan otras apps

(bancarias, retail) con el mismo patrón.

Dónde escribir memos:

- En tu software CAQDAS (NVivo, ATLAS.ti) vinculados a segmentos de datos

- En un cuaderno físico (algunos investigadores prefieren esto, yo incluida)

- En Notion/Obsidian como base de conocimiento

Fase 5: Codificar los datos (el corazón del análisis)

¿Qué es un código?

Un código es una etiqueta breve y descriptiva que asignas a un segmento de datos. Piensa en códigos como “etiquetas de Instagram” para tus datos.

Ejemplo de segmento codificado:

Participante: “Intenté buscar mi médico, pero no aparecía. Busqué por nombre, por especialidad… nada. Al final llamé al call center y me lo agendaron ellos.”

Códigos posibles: (al inicio de la codificación van a ser muy generales o quizás muy acotados, per oa medida que vas codificando más entrevistas, empiezan a aparecer patrones y códigos consistentes)

Búsqueda fallidaFrustración con buscadorWorkaround: llamar call centerProblema usabilidad

Las 3 fases del coding

Primera pasada: Codificación descriptiva (bajo nivel de inferencia)

- Asigna códigos a TODO el dataset

- Usa códigos descriptivos y literales

- Objetivo: Reducir el volumen de datos, marcar lo importante

Ejemplo:

Menciona frustraciónNo encontró la funciónCompara con app bancaria

Segunda pasada: Codificación interpretativa (nivel medio de inferencia)

- Revisa los segmentos ya codificados

- Asigna códigos más conceptuales

- Conecta con tus preguntas de investigación

Ejemplo:

Expectativa no cumplida(en lugar de “No encontró la función”)Modelo mental de otras apps(en lugar de “Compara con app bancaria”)

Tercera pasada: Codificación teórica (alto nivel de inferencia)

- Conecta códigos con conceptos teóricos o frameworks UX

- Vincula con heurísticas, principios de diseño, teorías

Ejemplo:

Violación heurística: Visibilidad del estado del sistema(Nielsen)Falta de affordance(Don Norman)Brecha entre modelo mental y modelo del sistema

Consejos para codificar

Haz:

- Inicia con 50-80 códigos (luego los agruparás)

- Codifica la misma frase con múltiples códigos si aplica

- Revisa tus códigos cada 2-3 entrevistas para consistencia

- Mantén un codebook (glosario de códigos con definiciones)

Ten cuidado de:

- Crear 300+ códigos (demasiado granular)

- Códigos de una sola palabra sin contexto (

problema,bueno) - Codificar solo lo que “confirma” tu hipótesis (sesgo de confirmación)

Herramienta: La mayoría de CAQDAS (NVivo, ATLAS.ti, Dedoose) permiten:

- Codificar segmentos de texto

- Ver frecuencia de códigos

- Filtrar por participante, fecha, etc. Yo no uso ninguno de estos porque requieren inversión, en ninguna empresa los han tenido y yo no los he pagado, solo en pregrado usé Atlas.ti, pero tiene curva de aprendizaje, así que uso Obsidian, excel, Google Drive, y un cuaderno.

Fase 6: De códigos → categorías → temas

Aquí es donde pasas de “muchas etiquetas” a “insights accionables”.

¿Qué es la diferencia?

| Nivel | Definición | Ejemplo |

|---|---|---|

| Código | Etiqueta descriptiva | Búsqueda fallida, Frustración, Llamó al call center |

| Categoría | Grupo de códigos relacionados | Problemas con buscador (agrupa: búsqueda fallida, filtros no funcionan, resultados irrelevantes) |

| Tema | Patrón significativo que responde a tu pregunta de investigación | Los usuarios recurren a canales tradicionales cuando la tecnología falla |

Proceso de agrupación

Paso 1: Imprime todos tus códigos (o ponlos en post-its)

- Búsqueda fallida

- Filtros no funcionan

- Resultados irrelevantes

- No encuentra médico por nombre

- Buscador no reconoce tildes

- Llamó al call center

- Pidió ayuda a familiar

- Fue presencialmente a sucursal

Paso 2: Agrupa códigos similares en categorías (como un card sorting cerrado :))

Categoría: "Problemas con buscador"

├─ Búsqueda fallida

├─ Filtros no funcionan

├─ Resultados irrelevantes

├─ No encuentra médico por nombre

└─ Buscador no reconoce tildes

Categoría: "Workarounds (soluciones alternativas)"

├─ Llamó al call center

├─ Pidió ayuda a familiar

└─ Fue presencialmente a sucursal

Paso 3: Identifica el patrón mayor (el tema)

Tema 1: “Cuando la tecnología falla, los usuarios regresan a canales tradicionales de confianza”

Este tema conecta:

- Problemas técnicos del buscador (causa)

- Workarounds tradicionales (efecto)

- Implicación para diseño: Mejorar buscador O facilitar contacto humano

Validación de temas:

Un buen tema debe:

- Ser evidente en múltiples participantes (no solo 1-2)

- Responder a tus preguntas de investigación

- Ser descriptivo y específico (no vago)

- Estar respaldado por evidencia (citas textuales)

Cuidado: “Los usuarios tienen problemas” (demasiado vago)

Mejor: “Los usuarios abandonan funciones digitales cuando requieren más de 2 intentos, prefiriendo contacto humano como red de seguridad”

Fase Transversal: Reflexividad - Tu Rol Como Investigador

Esta fase no es lineal — ocurre durante todo el proceso de análisis. Es uno de los marcadores de calidad más importantes en investigación cualitativa (Stenfors et al., 2020).

¿Por qué importa quién eres?

Un investigador UX senior analizando entrevistas de usuarios obtendrá insights diferentes que un diseñador junior analizando las mismas entrevistas. La reflexividad es reconocer cómo tu experiencia, sesgos y contexto influyen en tu análisis.

Un mismo dato puede interpretarse diferente según:

- Tu rol (¿Eres parte del equipo interno o consultor externo?)

- Tu experiencia previa (¿Has trabajado en fintech? ¿En salud digital?)

- Tu edad y contexto cultural

- Tus hipótesis previas sobre el problema

Preguntas de reflexividad que debes hacerte:

Antes del análisis:

- ¿Qué relación tengo con los participantes? (¿Soy parte del equipo? ¿Externo?)

- ¿Qué experiencia previa tengo con este tipo de producto/servicio?

- ¿Qué hipótesis tengo ANTES de leer los datos? (Escríbelas explícitamente)

- ¿Qué sesgos podría tener? (edad, género, expertise técnico, cultura)

Durante el análisis hazte algunas preguntas como por ejemplo:

- ¿Estoy buscando confirmar lo que el stakeholder quiere escuchar?

- ¿Estoy ignorando datos que contradicen mis creencias previas?

- ¿Mi background técnico/no técnico está influyendo en cómo interpreto “frustración”?

Ejemplo de reflexividad en acción:

Memo reflexivo:

## Memo Reflexivo: "Workarounds" vs Preferencias Legítimas (2025-02-13)

Hoy noté que estoy codificando todas las menciones de 'llamar al banco' como

'workaround' (solución alternativa). Pero reflexionando: ¿Es realmente un

workaround o es simplemente la preferencia legítima de usuarios >60 años que

confían más en interacción humana?

Mi sesgo: Yo (32 años, diseñadora digital) veo cualquier uso de canales no

digitales como 'fallo del sistema'. Debo reconsiderar si para algunos usuarios,

llamar NO es un workaround sino su canal preferido.

Acción: Revisar todos los códigos relacionados con "canal tradicional" y

re-evaluar si refleja falla del sistema o preferencia del usuario.

Cómo documentar tu reflexividad:

1. Declara tu posición en el reporte final:

Ejemplo:

“Como investigadora UX con 5 años de experiencia en fintech y background en diseño de interacción, realicé las entrevistas como consultora externa para [Empresa]. Mi familiaridad con patrones de UX bancaria puede haber influido en mi sensibilidad hacia problemas de usabilidad, mientras que mi posición externa facilitó que usuarios expresaran críticas al producto.”

2. Memos reflexivos durante el análisis (ver Fase 4)

Escribe memos específicamente sobre:

- Momentos donde notaste un sesgo personal

- Interpretaciones donde tu experiencia influyó

- Datos que te sorprendieron (porque contradecían tus expectativas)

3. Validación con personas de diferentes perfiles

- Presenta hallazgos preliminares a alguien sin tu background

- Pregúntales: “¿Qué interpretas tú de estos datos?”

- Si ven algo diferente, explora por qué

Por qué esto importa en UX Research:

- Tus stakeholders confiarán más en hallazgos transparentes

- Reconocer sesgos te hace mejor investigador, no peor

- La investigación cualitativa es co-construcción entre tú y los datos (no “verdad objetiva”)

- Mejora la credibilidad de tus hallazgos (Stenfors et al., 2020)

Herramienta práctica: Mantén un “Diario de Reflexividad”

Fecha | Observación reflexiva | Acción tomada

------|----------------------|---------------

2025-02-10 | Noté que estoy ignorando menciones positivas del buscador | Revisar datos y codificar también aspectos que funcionan bien

2025-02-12 | Mi background en e-commerce me hace asumir que "añadir a favoritos" es intuitivo | Validar si para usuarios >60 este concepto es claro

Fase 7: Transparencia y trazabilidad del análisis

¿Por qué importa?

Cuando presentas hallazgos a stakeholders o publicas un caso de estudio, necesitan confiar en que tu análisis fue riguroso, no solo “opiniones”.

3 estrategias de transparencia

1. Mapa de análisis (Audit Trail)

Crea una tabla que muestre el camino desde datos → tema:

| Cita textual (evidencia) | Código inicial | Categoría | Tema |

|---|---|---|---|

| “Busqué 10 minutos y nada… llamé al call center” | Búsqueda fallida → Workaround call center |

Problemas buscador / Workarounds | Retorno a canales tradicionales |

| “Mi hijo me ayudó a agendar, solo no pude” | Pidió ayuda familiar |

Workarounds | Retorno a canales tradicionales |

2. Mapa visual del proceso

Documenta tu proceso de análisis:

15 entrevistas

↓

[Fase 1-3] Preparar, transcribir, familiarizar

↓

[Fase 4-5] Memoing + Codificación (3 pasadas)

↓

157 códigos iniciales

↓

Agrupados en 23 categorías

↓

5 temas finales

3. Reporte de frecuencias (opcional, depende de tu audiencia)

Algunos stakeholders valoran cuantificar:

- “Tema 1: Retorno a canales tradicionales (mencionado por 11 de 15 participantes)”

- “Código ‘Frustración con buscador’: 47 menciones a lo largo del dataset”

Herramienta: NVivo, ATLAS.ti, y MAXQDA generan reportes de frecuencia automáticamente (esa es una ganancia frente a hacerlo manualmente).

Documentando Contexto para Transferibilidad

¿Por qué importa el contexto?

Un hallazgo sobre “usuarios que prefieren canales tradicionales” puede ser válido en tu estudio de una app bancaria chilena para usuarios >50 años, pero NO transferible a un estudio de una app de delivery para millennials en México.

“Los hallazgos pueden informar desarrollo de teoría y metodología, pero pueden no ser directamente transferibles a otros entornos sociales u organizacionales.” — Stenfors et al. (2020)

Transferibilidad NO es generalización estadística. En investigación cualitativa, el objetivo es que otros investigadores puedan evaluar si tus hallazgos aplican a su contexto, pero para eso necesitan conocer TU contexto en detalle.

Información contextual que es importante documentar:

1. Contexto de participantes:

## Perfil de Participantes

**Demografía:**

- Edad: 55-70 años (promedio: 62)

- Género: 8 mujeres, 7 hombres

- Educación: 60% educación superior, 40% secundaria completa

- Ocupación: 11 jubilados, 4 empleados

**Alfabetización digital:**

- Nivel básico: 40% (usan WhatsApp y email)

- Nivel intermedio: 53% (usan apps bancarias básicas)

- Nivel avanzado: 7% (usan múltiples apps fintech)

**Experiencia previa:**

- Todos usuarios de banco tradicional por 15+ años

- 80% usan banca en línea ocasionalmente

- 20% nunca usaron banca digital antes

**Ubicación:** Región Metropolitana, Chile (contexto urbano)

**Contexto cultural:** Usuarios chilenos con alta aversión al riesgo financiero

2. Contexto del producto:

## Características del Producto Estudiado

**Industria:** Banca retail (productos de ahorro e inversión)

**Tipo de producto:** App móvil iOS/Android

**Madurez:** Producto establecido (3 años en mercado)

**Competencia:** Mercado con 5 bancos tradicionales + 3 fintech

**Regulación:** Sujeto a normativa CMF (Comisión para el Mercado Financiero)

3. Contexto del estudio:

## Condiciones del Estudio

**Periodo:** Enero-Febrero 2025 (verano, post-fiestas)

**Método de reclutamiento:**

- 60% clientes actuales del banco (invitados por email)

- 40% panel de investigación UX (incentivados)

**Incentivo:** $30.000 CLP gift card (puede atraer participantes motivados por dinero)

**Modalidad:** Entrevistas remotas por Zoom (60-90 min)

**Entrevistador:** Investigadora UX externa (no empleada del banco)

**Contexto temporal relevante:**

- Post-crisis social 2019 (alta desconfianza en instituciones)

- Durante normalización post-COVID (usuarios volviendo a sucursales)

Statement de transferibilidad (ejemplo):

Al final de tu reporte de hallazgos, incluye:

Transferibilidad de hallazgos:

Estos hallazgos se basan en 15 entrevistas con usuarios chilenos de 55-70 años, con alfabetización digital básica-intermedia, usuarios actuales de una app bancaria tradicional en contexto urbano.

Los patrones identificados sobre ‘retorno a canales tradicionales cuando la tecnología falla’ probablemente son transferibles a:

- Otros contextos de banca digital para adultos mayores en Latinoamérica

- Servicios financieros de alto riesgo percibido (inversiones, créditos)

- Usuarios con baja confianza en instituciones digitales

Estos hallazgos probablemente NO son transferibles a:

- Usuarios nativos digitales (18-35 años)

- Industrias de menor riesgo percibido (apps de delivery, entretenimiento)

- Contextos donde sucursales físicas no existen (bancos 100% digitales)

- Países con alta penetración de fintech (ej: Brasil, México urbano)

Template de documentación contextual:

Usa esta estructura al escribir tu reporte de investigación:

# Contexto del Estudio

## 1. Objetivo y Pregunta de Investigación

[¿Qué querías responder?]

## 2. Participantes

- Criterios de inclusión/exclusión

- Demografía

- Nivel de experiencia relevante

- Método de reclutamiento

## 3. Producto/Servicio Estudiado

- Industria y categoría

- Madurez del producto

- Contexto competitivo

## 4. Método de Recolección

- Técnica (entrevistas, observación, etc.)

- Duración y modalidad

- Periodo de recolección

- Quién realizó la recolección

## 5. Contexto Temporal y Cultural

- Eventos relevantes del periodo

- Contexto sociocultural que influye en hallazgos

## 6. Limitaciones Conocidas

[Ej: "Solo usuarios urbanos, no rurales"]

## 7. Transferibilidad Estimada

[Dónde SÍ y dónde NO aplicarían estos hallazgos]

Por qué es relevante en UX Research:

- Tus stakeholders pueden evaluar si aplicar hallazgos a otros productos

- Otros equipos de investigación pueden replicar tu estudio en su contexto

- Evitas que se generalicen hallazgos incorrectamente

Asegurando calidad en tu análisis temático

Stenfors, Kajamaa y Bennett (2020) proponen criterios de calidad específicos para investigación cualitativa. Aquí los adapto para UX Research:

Los 5 criterios de trustworthiness (confiabilidad)

Según Stenfors et al. (2020), estos son los criterios que definen calidad en investigación cualitativa:

| Criterio | Qué significa | Cómo reconocerlo en tu análisis |

|---|---|---|

| Credibilidad | Los hallazgos son plausibles y confiables | Hay alineación entre teoría, pregunta de investigación, recolección de datos, análisis y resultados. El método de muestreo, profundidad de datos y pasos analíticos son apropiados |

| Dependabilidad | El estudio podría replicarse en condiciones similares | Documentaste suficiente información para que otro investigador siga los mismos pasos (aunque posiblemente llegue a conclusiones diferentes) |

| Confirmabilidad | Hay vínculo claro entre datos y hallazgos | Muestras cómo llegaste a tus hallazgos mediante descripciones detalladas y uso de citas textuales |

| Transferibilidad | Los hallazgos pueden aplicarse a otro contexto | Descripción detallada del contexto en que se realizó la investigación y cómo esto moldeó los hallazgos |

| Reflexividad | Proceso continuo de articular el rol del investigador | Explicaciones de cómo la reflexividad estuvo presente y fue documentada durante la investigación |

¿Cuándo dejar de entrevistar? Information Power vs Saturación

El mito de la saturación:

Muchos investigadores dicen: “Paro hasta que no surjan códigos nuevos” (saturación teórica). Problema: Este concepto es problemático, mal entendido y puede ser contraproducente (Varpio et al., 2017).

¿Por qué “saturación” es problemático?

- Implica que existe una “verdad completa” que descubrir

- No considera que SIEMPRE pueden surgir nuevos códigos con más datos

- Puede usarse como excusa para dejar de recolectar datos prematuramente

Mejor concepto: Information Power (Malterud et al., 2016; Varpio et al., 2017)

Tu muestra tiene suficiente information power cuando tus datos permiten:

- Responder tu pregunta de investigación con confianza

- Transferibilidad a contextos similares (con descripción adecuada del contexto)

- Alineación metodológica con tu enfoque (narrow study = menos datos; broad study = más datos)

Factores que determinan cuántos participantes necesitas:

| Factor | Menos participantes OK | Más participantes necesarios |

|---|---|---|

| Alcance del estudio | Narrow (ej: “flujo de pago específico”) | Broad (ej: “experiencia completa del servicio”) |

| Especificidad de muestra | Muy específico (ej: “médicos cardiólogos >50 años”) | General (ej: “usuarios de salud digital”) |

| Uso de teoría | Estudio basado en teoría sólida existente | Estudio exploratorio sin teoría previa |

| Calidad del diálogo | Entrevistas profundas de 90 min con alta información | Entrevistas superficiales de 20 min |

| Estrategia de análisis | Análisis temático (flexible) | Grounded theory (requiere más datos) |

Ejemplo práctico:

Estudio A: “¿Por qué usuarios de 60+ abandonan el flujo de pago en nuestra app bancaria específica?”

- Alcance: Narrow (solo un flujo específico)

- Muestra: Específica (60+, app bancaria, Chile)

- Teoría: Basada en heurísticas de usabilidad (Nielsen)

- Calidad: Entrevistas profundas con screen sharing

- Participantes necesarios: 8-12

Estudio B: “¿Cómo personas de bajos ingresos gestionan sus finanzas digitalmente?”

- Alcance: Broad (todas las finanzas digitales: bancos, billeteras, créditos)

- Muestra: General pero diversa (diferentes apps, bancos, contextos)

- Teoría: Exploratoria (sin framework previo)

- Calidad: Entrevistas contextuales en terreno

- Participantes necesarios: 25-40

Cómo saber si tienes suficiente information power:

En lugar de buscar “saturación”, pregúntate:

Checklist de information power:

- [ ] ¿Puedo responder mi pregunta de investigación con estos datos?

- [ ] ¿Tengo suficiente evidencia (citas de múltiples participantes) para respaldar cada tema?

- [ ] ¿Entrevisté a diferentes “tipos” de usuarios relevantes para mi contexto? (ej: novatos y expertos, jóvenes y mayores)

- [ ] ¿Los stakeholders pueden tomar decisiones de diseño con esta información?

- [ ] ¿Documenté suficiente contexto para que otros evalúen transferibilidad?

- [ ] ¿Los temas responden preguntas que importan al negocio/producto?

** Sí a las 6 preguntas → Tienes suficiente information power**

En concreto: En lugar de decidir “haremos 15 entrevistas”, plantea:

- “Haremos entre 10-20 entrevistas, evaluando information power cada 5 entrevistas”

- Esto permite flexibilidad basada en riqueza de datos, no en número arbitrario

Validación con Participantes (Member Reflections)

¿Qué es?

Presentar tus hallazgos preliminares a algunos participantes originales para (Stenfors et al., 2020):

- Verificar que tu interpretación resuena con su experiencia

- Elaborar o profundizar en temas emergentes

- Identificar interpretaciones erróneas

¿Es obligatorio? No. Es una estrategia OPCIONAL que puede mejorar la credibilidad del análisis.

Cómo hacerlo:

Paso 1: Selecciona 3-5 participantes representativos de diferentes “tipos” en tu muestra

Paso 2: Prepara hallazgos preliminares (1 página, lenguaje simple, sin jerga académica)

Paso 3: Envía por email o agenda sesión de 30 min

Paso 4: Pregunta:

- “¿Estos hallazgos resuenan con tu experiencia?”

- “¿Hay algo que falta o está mal interpretado?”

- “¿Puedes elaborar más sobre [tema específico]?”

Ejemplo de email para member reflection:

Asunto: Validación de hallazgos - Estudio UX App Bancaria

Hola [Nombre],

Gracias nuevamente por participar en nuestra investigación sobre [tema].

Hemos completado el análisis preliminar y me gustaría validar nuestros

hallazgos contigo.

**Hallazgo clave identificado:**

Usuarios como tú recurren a canales tradicionales (call center, sucursal)

cuando el buscador digital falla más de 2 veces, priorizando la eficiencia

sobre la digitalización. Esto sucede especialmente en tareas de alto riesgo

percibido como agendar hora médica o transferencias grandes.

**Preguntas:**

1. ¿Esta interpretación refleja tu experiencia?

2. ¿Hay matices que deberíamos considerar?

3. ¿Qué más agregarías sobre este patrón?

Agradecería 15 minutos de tu tiempo para discutir esto brevemente.

Puedo llamarte o hacer una videollamada corta.

Gracias,

[Tu nombre]

Cuándo NO usar member reflections:

- Cuando los participantes son stakeholders con agenda (pueden sesgar hacia hallazgos que favorecen sus intereses)

- Cuando el análisis es crítico/sensible (ej: hallazgos negativos sobre la empresa del participante)

- Cuando el estudio es etnográfico y los participantes no son conscientes de patrones culturales propios

- Cuando tienes restricciones de tiempo/presupuesto severas

Alternativa a member reflections: Validación con otros investigadores o stakeholders diversos (triangulación de perspectivas)

Checklist de calidad (Braun & Clarke, 2006)

Usa este checklist antes de presentar hallazgos:

Transcripción:

- [ ] Las transcripciones son precisas y representan los datos originales

- [ ] Revisé las transcripciones vs audio al menos una vez

Codificación:

- [ ] Cada segmento de datos relevante fue codificado

- [ ] Los códigos son consistentes a lo largo del dataset

- [ ] No forcé los datos para “confirmar” mi hipótesis previa

- [ ] Codifiqué todo el dataset, no solo las partes “interesantes”

Temas:

- [ ] Los temas son patrones coherentes, no solo códigos agrupados

- [ ] Hay suficiente evidencia (citas) para cada tema

- [ ] Los temas responden a mi pregunta de investigación

- [ ] No confundí “temas” con “preguntas de mi guion de entrevista”

Reporte:

- [ ] El reporte balancea descripción analítica con citas ilustrativas

- [ ] Documenté mi proceso de análisis (audit trail)

- [ ] Las interpretaciones están fundamentadas en datos

- [ ] Fui transparente sobre las limitaciones del análisis

Frameworks de Calidad Reconocidos Académicamente

Cuando presentes hallazgos a stakeholders académicos, de research ops, o para publicación, podrían preguntarte: “¿Seguiste COREQ/SRQR?”

Estos son frameworks estandarizados para reportar investigación cualitativa con rigor académico.

COREQ (Consolidated Criteria for Reporting Qualitative Research)

32 ítems organizados en 3 dominios (Tong et al., 2007):

1. Research team & reflexivity (8 items)

- ¿Quién hizo las entrevistas? (credenciales, género, experiencia, capacitación)

- ¿Qué relación tenían con participantes? (insider vs outsider)

- ¿Qué motivó el estudio? (intereses, razones personales/profesionales)

2. Study design (15 items)

- Marco teórico que guía el estudio

- Selección de participantes (criterios, método de contacto, tamaño de muestra)

- Setting (dónde se hicieron las entrevistas: presencial, remoto, lugar específico)

- Presencia de no-participantes durante entrevistas

- Descripción de la guía de entrevista (preguntas piloto, versiones)

- Entrevistas repetidas (si se hicieron y por qué)

- Grabación de audio/video

- Notas de campo (quién las tomó, cuándo)

- Duración de entrevistas

- Data saturation (o information power)

- Transcripciones (quién las hizo, validación con participantes)

3. Analysis & findings (9 items)

- Número de codificadores y características

- Descripción del coding tree (codebook)

- Derivación de temas (proceso de agrupación)

- Software usado (NVivo, ATLAS.ti, manual)

- Participant checking (member reflections)

- Citas presentadas (identificación de participantes)

- Consistencia entre datos y hallazgos

- Claridad entre hallazgos mayores y menores

- Reporte completo de resultados

Cuándo usar COREQ:

- Publicaciones académicas

- Reportes para comités de ética

- Estudios que se usarán como evidencia científica

- Research ops de alta rigurosidad

Descarga el checklist completo: COREQ 32-item checklist

SRQR (Standards for Reporting Qualitative Research)

21 ítems para reportes de investigación cualitativa (O’Brien et al., 2014)

Similar a COREQ pero más enfocado en educación médica, salud y UX research.

Categorías principales:

- Título y resumen

- Introducción (problema, propósito, pregunta)

- Métodos (paradigma, características del investigador, contexto, muestreo, datos éticos, colección de datos, procesamiento, análisis)

- Resultados (síntesis, interpretación)

- Discusión (links con literatura, transferibilidad)

- Otros (financiamiento, conflictos de interés)

Cuándo usar SRQR:

- Investigación en salud digital

- Estudios de comportamiento del usuario

- Research ops en empresas reguladas

Descarga el checklist completo: SRQR Guidelines

CASP (Critical Appraisal Skills Programme)

10 preguntas para evaluar estudios cualitativos:

- ¿Hay una declaración clara de los objetivos de la investigación?

- ¿Es apropiada la metodología cualitativa?

- ¿Es apropiado el diseño de investigación para abordar los objetivos?

- ¿Es apropiada la estrategia de reclutamiento?

- ¿Los datos fueron recolectados de manera apropiada?

- ¿Se consideró adecuadamente la relación investigador-participante?

- ¿Se consideraron los temas éticos?

- ¿Fue riguroso el análisis de datos?

- ¿Hay una declaración clara de hallazgos?

- ¿Qué tan valiosa es la investigación?

Cuándo usar CASP:

- Para auto-evaluar tu estudio antes de presentarlo

- Para revisar estudios de otros como benchmark

- Para enseñar calidad en investigación cualitativa

Descarga: CASP Qualitative Checklist

¿Qué framework usar?

Para proyectos UX internos corporativos:

- Braun & Clarke (2006) checklist es suficiente

- Agrega criterios de trustworthiness (Stenfors et al., 2020)

Para research ops o estudios de alta rigurosidad:

- Usa COREQ (entrevistas/focus groups) o SRQR (cualquier método cualitativo)

- Documenta durante el estudio, no al final

Para publicaciones académicas o científicas:

- Revistas te requerirán COREQ o SRQR explícitamente

- Algunos journals tienen sus propias guías (revisa author guidelines)

Consejo práctico:

Descarga el checklist relevante ANTES de empezar tu estudio. Úsalo como guía para documentar durante la investigación, no como checklist post-hoc.

Ejemplo: Si sabes que necesitarás COREQ, documenta desde el día 1:

- Quién hizo las entrevistas

- Duración exacta de cada entrevista

- Notas de campo

- Proceso de transcripción

- Etc.

Es más fácil documentar en tiempo real que reconstruir meses después.

Errores comunes (y cómo evitarlos)

Error 1: Confundir temas con resumen de preguntas

Mal tema: “Lo que los usuarios dijeron sobre el buscador”

Buen tema: “El buscador actual no cumple con el modelo mental de búsqueda simple que los usuarios traen de Google y apps bancarias”

Solución: Los temas deben ser interpretaciones, no descripciones.

Error 2: Temas basados en frecuencia solamente

Mal razonamiento: “Este código apareció 50 veces, así que es un tema”

Buen razonamiento: “Este patrón es relevante porque responde a nuestra pregunta clave sobre por qué los usuarios abandonan el flujo”

Solución: La relevancia > frecuencia.

Error 3: Sesgo de confirmación

Sesgo: Solo codifico lo que confirma que “el buscador es malo” (mi hipótesis previa)

Rigor: Codifico TODO, incluyendo casos donde el buscador funcionó bien o donde el problema fue otra cosa

Solución: Busca activamente evidencia que contradiga tus hipótesis.

Error 4: Análisis superficial

Superficial: “Tema 1: Problemas de usabilidad. Tema 2: Sugerencias de mejora.”

Profundo: “Los usuarios interpretan la falta de resultados como fallo del sistema, no como ausencia real del dato, lo que genera desconfianza en toda la app”

Solución: Pregúntate “¿Y qué?” hasta llegar a insights accionables.

Ejemplo completo: De transcripción a tema

Datos brutos (transcripción)

Entrevistador: ¿Cómo fue tu experiencia buscando un médico en la app?

P08: Uff, frustrante. Busqué “cardiólogo” y me salieron como 20, pero ninguno en mi comuna. No había forma de filtrar por ubicación. Intenté escribir “cardiólogo Las Condes” pero no funcionó. Al final llamé al call center y me agendaron en 2 minutos. Fue más rápido lo tradicional.

Codificación (3 pasadas)

Primera pasada (descriptivo):

FrustraciónBúsqueda por especialidadResultados no relevantes geográficamenteFiltro de ubicación no disponibleBúsqueda en lenguaje natural fallóLlamó call centerCall center fue más rápido

Segunda pasada (interpretativo):

Expectativa de filtro geográfico no cumplidaModelo mental de búsqueda tipo Google (lenguaje natural)Workaround: canal tradicionalComparación eficiencia: digital < humano

Tercera pasada (teórico):

Brecha entre modelo mental (Google) y modelo del sistemaViolación heurística: Flexibilidad y eficiencia de uso (Nielsen #7)

Categorización

Categoría 1: Problemas de búsqueda

- Resultados no relevantes geográficamente

- Filtro de ubicación no disponible

- Búsqueda en lenguaje natural falló

Categoría 2: Workarounds

- Llamó call center

- Call center fue más rápido

Tema emergente

Tema: “Los usuarios esperan capacidades de búsqueda inteligente (tipo Google) que la app actual no ofrece, llevándolos a preferir canales humanos tradicionales que resuelven su necesidad en menos pasos.”

Implicación para diseño:

- Agregar filtro de ubicación geográfica en buscador

- O bien, implementar búsqueda en lenguaje natural (“cardiólogo en Las Condes”)

- O bien, destacar opción de “Hablar con un asesor” como alternativa legítima

Herramientas recomendadas

Software CAQDAS (Computer-Assisted Qualitative Data Analysis)

| Herramienta | Precio | Pros | Contras |

|---|---|---|---|

| NVivo | $1,500 USD (licencia académica más barata) | Muy completo, estándar en investigación | Curva de aprendizaje empinada |

| ATLAS.ti | $99-700 USD/año | Interface más intuitiva | Menos funciones que NVivo |

| MAXQDA | €1,500 (licencia perpetua) | Excelente para equipos | Caro para freelancers |

| Dedoose | $15/mes | Basado en web, colaborativo | Requiere internet siempre |

| Delve | Gratis (básico) | Gratuito, fácil de usar | Funciones limitadas |

Mi recomendación para empezar: Dedoose o Delve (bajo costo). Si tu organización paga, NVivo o ATLAS.ti.

Alternativas low-tech

- Excel/Google Sheets: Funciona para proyectos pequeños (5-10 entrevistas)

- Notion: Con una base de datos bien estructurada, puedes codificar manualmente

- Papel y post-its: Sorprendentemente efectivo para proyectos de 3-5 entrevistas

Tiempo estimado por fase

Para un proyecto típico de 12 entrevistas de 60 minutos:

| Fase | Tiempo estimado |

|---|---|

| 1. Preparar y organizar | 2-3 horas |

| 2. Transcribir (con herramienta automática + revisión) | 15-20 horas |

| 3. Familiarización | 6-12 horas |

| 4. Memoing (continuo durante codificación) | 5-8 horas |

| 5. Codificación (3 pasadas) | 25-35 horas |

| 6. Categorización y temas | 8-12 horas |

| 7. Documentar proceso | 4-6 horas |

| TOTAL | 65-96 horas (~2-2.5 semanas a tiempo completo) |

Consejo: No subestimes el tiempo de análisis. Como regla general: 1 hora de entrevista = 6-8 horas de análisis completo.

Recursos adicionales para profundizar

Lecturas esenciales

-

Braun, V., & Clarke, V. (2006). “Using thematic analysis in psychology.” Qualitative Research in Psychology, 3, 77-101.

- El paper fundacional del análisis temático moderno. Lectura obligada.

-

Braun, V., & Clarke, V. (2013). “Successful Qualitative Research: A Practical Guide for Beginners.”

- Libro completo, muy didáctico, con ejemplos paso a paso.

-

Saldaña, J. (2016). “The Coding Manual for Qualitative Researchers.”

- Referencia definitiva sobre codificación. 30+ métodos de coding explicados.

-

Lester, J. N., Cho, Y., & Lochmiller, C. R. (2020). “Learning to Do Qualitative Data Analysis: A Starting Point.”

- Artículo que inspiró este blog post. Muy práctico para principiantes.

Cursos recomendados

- Coursera: “Qualitative Research Methods” (University of Amsterdam)

- LinkedIn Learning: “Qualitative Research Design and Methods” por Erin Meyer

- UXPA: Workshops presenciales sobre análisis cualitativo

Comunidades

- ResearchOps Community: Slack con canal dedicado a análisis cualitativo

- UX Research Geeks: Facebook group con threads sobre coding

- Reddit r/userexperience: Subreddit con discusiones de métodos

Conclusión: Tu roadmap de aprendizaje

El análisis temático no es “leer entrevistas y sacar conclusiones”. Es un proceso sistemático, riguroso y transparente que requiere práctica.

Tu plan de acción:

- Semana 1: Lee Braun & Clarke (2006). Familiarízate con las 7 fases.

- Semana 2: Analiza 3 entrevistas piloto con este framework. No importa si no es perfecto.

- Semana 3: Revisa tu primer análisis. Identifica dónde tuviste dificultades.

- Semana 4: Analiza un proyecto real completo (10-15 entrevistas).

- Mes 2+: Practica con diferentes tipos de datos (observaciones, encuestas abiertas, etc.).

Recuerda:

“No existe una única forma correcta de analizar datos cualitativos; lo esencial es encontrar maneras de usar los datos para pensar.” — Coffey & Atkinson (1996)

El análisis temático es tu base. Una vez lo domines, podrás explorar métodos más especializados (Grounded Theory, Discourse Analysis, Framework Analysis). Pero esta base te servirá para siempre.

¿Preguntas? ¿Quieres compartir tu experiencia con análisis temático? Déjame un comentario o escríbeme directamente.

Serie: Dominando el Análisis Cualitativo

Este artículo es parte de una serie sobre análisis de datos en UX Research:

- Guía Completa de Análisis Temático (estás aquí)

- Próximamente: Cómo comunicar hallazgos cualitativos a stakeholders

- Próximamente: Análisis de contenido vs análisis temático: ¿cuándo usar cada uno?

Si este artículo te fue útil, también te puede interesar:

- Cómo elegir la metodología de UX Research correcta

- Guía completa de User Journey Map

- Entrevistas de stakeholders: guía y template

Referencias bibliográficas:

- Anderson, V. (2017). Criteria for evaluating qualitative research. Human Resource Development Quarterly, 28(2), 125–133.

- Braun, V., & Clarke, V. (2006). Using thematic analysis in psychology. Qualitative Research in Psychology, 3, 77–101.

- Braun, V., & Clarke, V. (2016). (Mis)conceptualising themes, thematic analysis, and other problems. International Journal of Social Research Methodology, 19(6), 739–743.

- Lester, J. N., Cho, Y., & Lochmiller, C. R. (2020). Learning to Do Qualitative Data Analysis: A Starting Point. Human Resource Development Review, 19(1), 94–106.

- Malterud, K., Siersma, V. D., & Guassora, A. D. (2016). Sample size in qualitative interview studies: Guided by information power. Qualitative Health Research, 26(13), 1753–1760.

- O’Brien, B. C., Harris, I. B., Beckman, T. J., Reed, D. A., & Cook, D. A. (2014). Standards for reporting qualitative research: A synthesis of recommendations. Academic Medicine, 89(9), 1245–1251.

- Saldaña, J. (2016). The coding manual for qualitative researchers (3rd ed.). Sage.

- Stenfors, T., Kajamaa, A., & Bennett, D. (2020). How to assess the quality of qualitative research. The Clinical Teacher, 17(6), 596–599.

- Terry, G., Hayfield, N., Clarke, V., & Braun, V. (2017). Thematic analysis. In C. Willig & W. S. Rogers (Eds.), The SAGE handbook of qualitative research in psychology (2nd ed., pp. 17–37). Sage.

- Tong, A., Sainsbury, P., & Craig, J. (2007). Consolidated criteria for reporting qualitative research (COREQ): A 32-item checklist for interviews and focus groups. International Journal for Quality in Health Care, 19(6), 349–357.

- Varpio, L., Ajjawi, R., Monrouxe, L. V., O’Brien, B. C., & Rees, C. E. (2017). Shedding the cobra effect: Problematising thematic emergence, triangulation, saturation and member checking. Medical Education, 51(1), 40–50.